Solutions & Technologies

AI 数据中心网络

可以节省时间和支出的简单、无缝运维人员体验

生成式人工智能 (AI) 领域的最新进展激发了全球数亿人的无限想象,也让 AI 和机器学习 (ML) 成为企业关注的焦点。数据中心是 AI 背后的引擎,而数据中心网络在互连以及最大限度利用成本高昂的 GPU 服务器方面发挥着至关重要的作用。

以工作完成时间 (JCT) 来衡量效率的 AI 训练是一个庞大的并行处理问题。您需要有一个快速可靠的网络交换矩阵来充分利用您那成本高昂的 GPU。构建合适的网络是优化投资回报的关键所在,而方法很简单,只需保证网络得到正确设计,即可大幅节省 AI 应用方面的支出。

瞻博网络可以助您一臂之力

瞻博网络的 AI 数据中心解决方案是一种可快速部署高性能 AI 训练和推理网络的方法。这样的网络设计灵活,便于在 IT 资源有限的情况下进行管理。我们集成了业界领先的 AIOps 和世界一流的网络技术,帮助客户轻松构建易于运维的大容量网络交换矩阵,能够尽可能缩短 JCT,提高 GPU 利用率,并充分利用有限的 IT 资源。

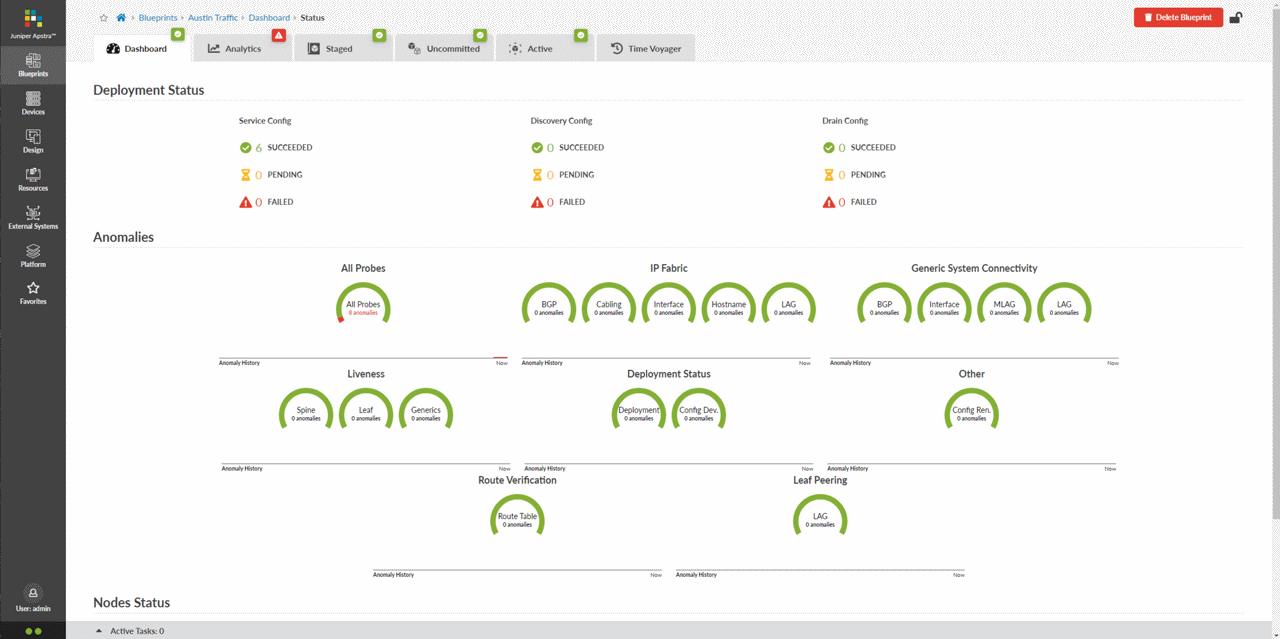

至简运维节省网络相关 OpEx 高达 90%

我们运维优先的方法可节省时间和资金,避免供应商锁定。Apstra Data Center Director 基于意图的独特自动化功能可保护运维人员免受网络复杂性的影响并加快部署。Marvis 数据中心 AI 助手提供了全新数据中心 AIOps 功能,进一步提升运维人员和最终用户的体验,让客户能够主动发现并快速解决问题。因此,使用瞻博网络构建 AI 数据中心网络,部署速度可以加快高达 85%。

Forrester 对 Apstra Data Center Director 进行了整体经济影响研究,发现一家典型组织实现了高达 320% 的投资回报率,投资回收期不到 6 个月。

与所有领先的 GPU、交换矩阵和交换机实现 100% 的可互操作

企业使用供应商锁定的专有解决方案可能会阻碍 AI 创新。瞻博网络的解决方案能够确保最快的创新速度,尽可能提高设计灵活性,并避免后端、前端和存储 AI 网络的供应商锁定。我们的开放式 AI 优化以太网解决方案可确保功能速度和成本节省,而 Data Center Director 则是跨多供应商网络进行数据中心运维和保证的唯一解决方案。有了瞻博网络,您可以自由选择任何 GPU、交换矩阵和交换机,以最大限度地满足数据中心网络的独特需求。

想要了解 IDC 关于“AI 无处不在”的转变如何影响数据中心基础架构以及大型企业如何托管其 AI 应用的最新研究?

全包式解决方案带来高达 10 倍的可靠性提升

帮助您灵活轻松地部署高性能 AI 数据中心,从交换和路由,到运维和安全性,全面涵盖,滴水不漏。瞻博网络验证设计 (JVD) 可简化部署和故障排除流程,让您可以自信而快速地构建下一个功能强大的 AI 模型。我们的产品具有芯片多样性,有助扩大规模、改善性能和提高客户灵活性,而集成式安全性解决方案又可以保护 AI 工作负载和基础架构免受网络攻击。

想深入了解瞻博网络 AI 数据中心解决方案如何帮助您提高效率、降低运营支出,并缩短 JCT?下载我们的《AI 数据中心网络》白皮书。

亲自了解我们的解决方案

确保我们的解决方案能够帮助您加快实现价值。符合条件的客户和合作伙伴可以参观访问我们位于加利福尼亚州森尼韦尔(Sunnyvale, CA) 的 Ops4AI 实验室,在基于以太网的网络交换矩阵中使用先进 GPU 计算、存储技术和自动化运维,测试 AI 工作负载。在瞻博网络、Broadcom、Intel、Nvidia、WEKA 等公司的硬件上试运行尖端 AI 模型。

探索 Networking for AI

了解以太网解决方案如何灵活轻松地克服 AI 数据中心网络的常见障碍。观看视频,了解瞻博网络的开放式 AI 优化以太网解决方案如何在避免产生专利技术费用和造成任何不便的前提下,确保实现与 InfiniBand 相媲美的功能速度。

比较 Data Center Director 与 Cisco 数据中心解决方案

了解解决方案的实际应用

客户成功案例

SambaNova 让高性能和受计算限制的机器学习变得简单且可扩展

人工智能有望转变医疗保健、金融服务、制造、零售和其他行业,但很多致力于提高人类工作速度和效率的组织尚未充分发挥人工智能的潜力。

为克服受计算限制的机器学习 (ML) 的复杂性,SambaNova 设计出了 DataScale。DataScale 采用 SambaNova Systems 的 Reconfigurable Dataflow Architecture (RDA) 设计,并且使用开放标准和用户界面构建而成,是一款从算法到芯片都得到优化的集成式软硬件系统平台。瞻博网络交换解决方案为 SambaNova 的 DataScale 系统和服务迁移了大量数据。

资源中心

博客

报告

白皮书

视频

AI 数据中心网络常见问题解答

如今,哪些类型的企业优先考虑在其数据中心内部署 AI/ML 解决方案?

AI 需求正在推动超大规模企业、云提供商、企业、政府和教育机构将 AI 纳入其业务系统中,实现自动运维、生成内容和通信,并改善客户服务水平。

AI 训练和推理阶段之间有何区别?

AI 模型使用训练阶段精心制作的数据集构建而成。训练在群集中的多个 GPU 上进行。这些 GPU 可以有数十个、数百个,甚至多达数千个,均通过网络连接,并不断相互交换数据。训练阶段结束后,模型也基本构建完成。在推理阶段,用户与模型进行交互,模型可以识别图像或生成图片和文本,回答用户的问题。训练通常以离线方式进行,而推理则通常在线上完成。

AI 数据中心网络基础架构解决方案包含哪些组件?瞻博网络又是如何利用这些组件的?

海量 AI 数据集需要更强大的计算能力、更快速的存储以及大容量、低延迟的网络。瞻博网络通过以下方式满足这些要求:

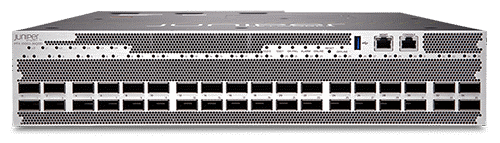

- 计算:AI/ML 计算群集对节点间网络提出了苛刻的要求。缩短工作完成时间 (JCT) 是其中一个必要需求,而网络在群集的高效运维中发挥着关键作用。瞻博网络提供一系列高性能、无阻塞交换机,具备深度缓冲和拥塞管理功能,只需进行妥善架构,就能够消除一切网络瓶颈。

- 存储:在 AI/ML 群集和高性能计算中,很少数据集或模型能够被完整存储在计算节点上,因此需要用到高性能存储网络。瞻博网络 QFX 系列交换机可用于 IP 存储连接;此系列交换机对远程直接内存访问 (RDMA) 网络提供全面支持,包括非易失性存储器/聚合以太网 RDMA (NVMe/RoCE) 和网络文件系统 (NFS)/RDMA。

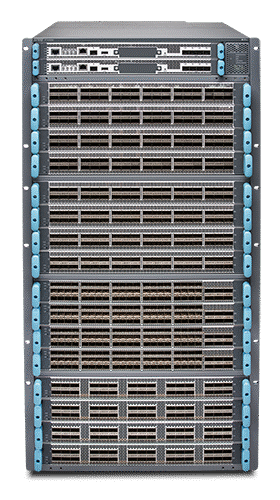

- 网络:AI 训练模型涉及分布在数百个或数千个 CPU、GPU 和 TPU 处理器上的大量密集计算。这些计算需要可横向扩展的无错大容量网络。瞻博网络 QFX 交换机和 PTX 系列路由器利用行业领先的交换和路由吞吐量以及数据中心互连 (DCI) 功能,为数据中心内和数据中心之间的大量计算提供支持。

瞻博网络 AI 数据中心如何简化数据中心的运维?

Data Center Director 是瞻博网络的行业领先数据中心自动化和保证软件。它通过持续验证、强大的分析和根本原因识别,在多供应商数据中心中自动执行从设计到日常运维的整个网络生命周期,从而保证可靠性。有了面向数据中心的 Marvis AI 助手,这些信息就能从 Data Center Director 传输到瞻博网络 Mist 云中,并显示在一个通用的 VNA 仪表板中,以提供端到端的洞察力。Marvis 数据中心 AI 助手还提供一个强大的对话界面(使用 GenAI),可显著简化知识库查询。

瞻博网络 AI 数据中心网络解决方案如何满足拥塞管理、负载平衡和延迟要求,从而最大限度提高 AI 性能?

瞻博网络的高性能、无阻塞数据中心交换机提供深度缓冲和拥塞管理功能,以消除网络瓶颈。我们支持动态负载平衡和自适应路由,对流量负载进行平衡。对于拥塞管理,瞻博网络全面支持数据中心量化拥塞通知 (DCQCN)、优先流控制 (PFC) 和显式拥塞通知 (ECN)。最后,为减少延迟,瞻博网络在主干架构中采用同类最佳的商用芯片、可在必要时最大限度利用缓冲区的自定义 ASIC 架构、虚拟输出队列 (VOQ) 以及基于单元的交换矩阵。

瞻博网络提供哪些 IP 存储功能?

我们的产品组合包括基于标准的开放式交换机,使用 NVMe/RoCE 或 NFS/RDMA 提供基于 IP 的存储连接(请参见先前的常见问题解答)。我们的 IP 存储网络解决方案设计可从小型四节点配置扩展到数百个或数千个存储节点。

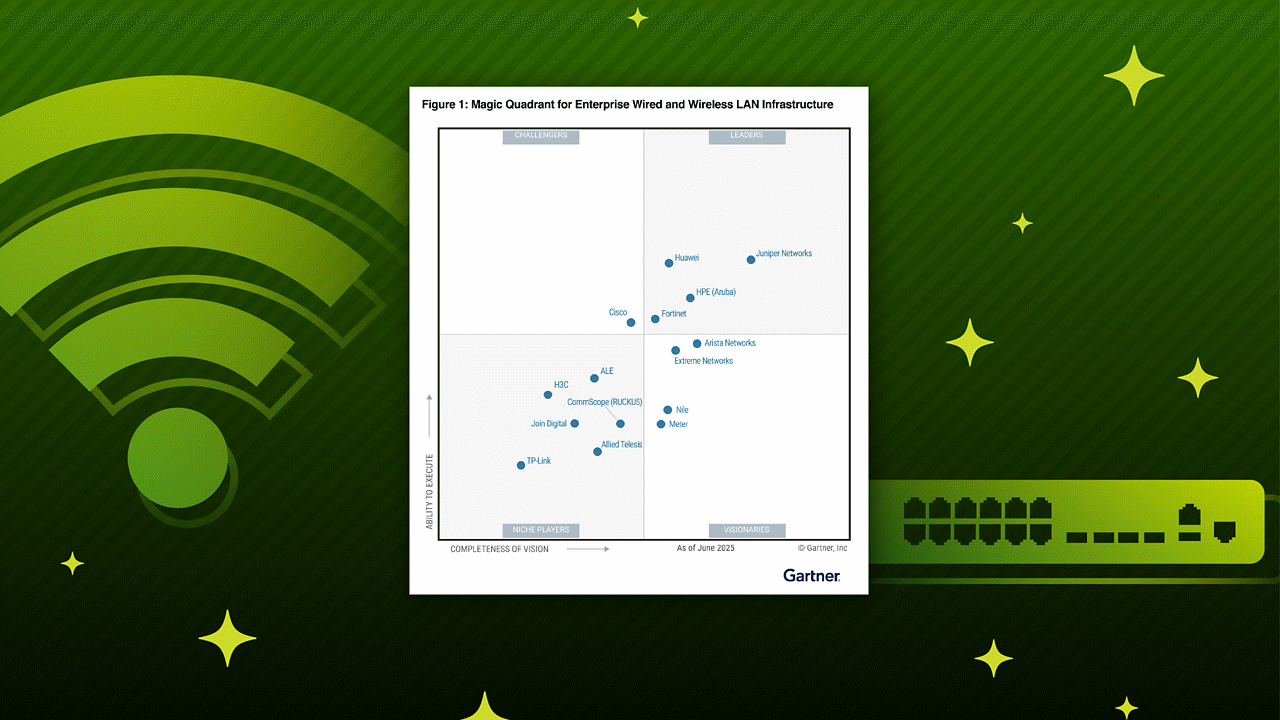

Gartner,《数据中心交换魔力象限》,作者:Andrew Lerner、Simon Richard 等,发布日期:2025 年 3 月 31 日

GARTNER 是 Gartner, Inc. 和/或其附属公司在美国及全球的注册商标和服务商标,MAGIC QUADRANT(魔力象限)是 Gartner, Inc. 和/或其附属公司的注册商标,经许可在此使用。保留所有权利。

本图表由 Gartner, Inc. 发布,系一份完整研究报告的一部分,应参照完整报告文档内容进行评估。您可以向瞻博网络索取该 Gartner 文档。

Gartner 不为其研究出版物中描述的任何供应商、产品或服务背书,也不建议技术用户仅选择评级最高或获得其他称号的供应商。Gartner 研究报告由 Gartner 研究机构的观点构成,不应解释为事实陈述。Gartner 对本研究不作任何明示或暗示的担保,包括对于适销性或特定用途适用性的担保。