什么是可解释的 AI (XAI)?

什么是可解释的 AI (XAI)?

可解释的 AI (Explainable AI) 是方便用户理解和信赖由 AI 机器学习 (ML) 算法计算所得结果和输出的一套过程和方法。有关 AI/ML 输出的补充解释或许只面向用户、运维或开发人员,但这些解释旨在解决用户采用、管理和开发系统等方面的各种问题和挑战。这种“可解释性”是 AI 在市场上获得信任和信心的核心,以促进 AI 的广泛采用,并充分发挥 AI 的优势。其他相关的新兴倡议还包括值得信赖的 AI 和负责任的 AI。

可解释的 AI 是如何实现的?

美国国家标准与技术研究院 (NIST) 指出,推动 XAI 的四项原则分别为:

- 解释:系统需要为所有输出提供补充证据或理由。

- 意义:系统要为个人用户提供可理解的解释。

- 解释准确性:解释能正确反映出系统生成输出的过程。

- 知识限制:系统仅在其设计条件下或者当其输出达到足够的置信水平时运行。

NIST·指出,解释可以是简单的,也可以是复杂的,具体取决于相关消费者。该机构使用以下五个非详尽的可解释性示例类别,来对部分解释类型进行了说明:

- 用户利益

- 社会认可度

- 监管与合规

- 系统开发

- 所有者利益

可解释的 AI 的重要性在何?

可解释的 AI 是在自动化系统中培养、获得和保持信任的关键因素。如果没有信任,AI,特别是面向 IT 运营的 AI (AIOps),将得不到充分接受,致使现代系统的规模和复杂性超过手动操作和传统自动化所能实现的程度。

而当我们建立起信任,“AI 漂洗” (AI washing) — 指企业声称产品或服务由 AI 驱动,但实际上根本没有使用 AI,或只使用了极少 AI — 的做法就会原形毕露,从而帮助从业者和客户对 AI 产品或服务去芜存菁。能否对 AI 建立信任和信心会影响 AI 的接纳范围和速度,进而会决定其效益实现的速度和范围。

如果我们需要任何系统 — 尤其是那些具有现实影响力的系统 — 去寻求答案或作出决策,我们就必须解释系统是如何得出决定、系统将如何影响结果,或是为什么认为行动是必须的。

可解释的 AI 的好处

可解释的 AI 能够带来多方面的好处。这些好处涉及明智决策、降低风险、增加信心和用户接纳度、优化管理、加速系统改进,以及促进 AI 在全球全面发展与应用等。

可解释的 AI 解决了什么问题?

许多 AI 和机器学习模型并不透明,且无法对其输出进行解释。能够揭示和解释遵循特定路径的理由或产生输出的过程,对于为 AI 争取信任、帮助 AI 发展和提高 AI 接纳度而言至关重要。

对数据、模型和流程进行解释,能够帮助运维人员和用户深入了解和观察这些系统,以便使用透明、有效的推理进行优化。最重要的是,可解释性能够降低有关漏洞、偏差和风险的沟通的难度,往后还能进一步降低,甚至完全消除。

可解释的 AI 如何提高透明度并建立信任

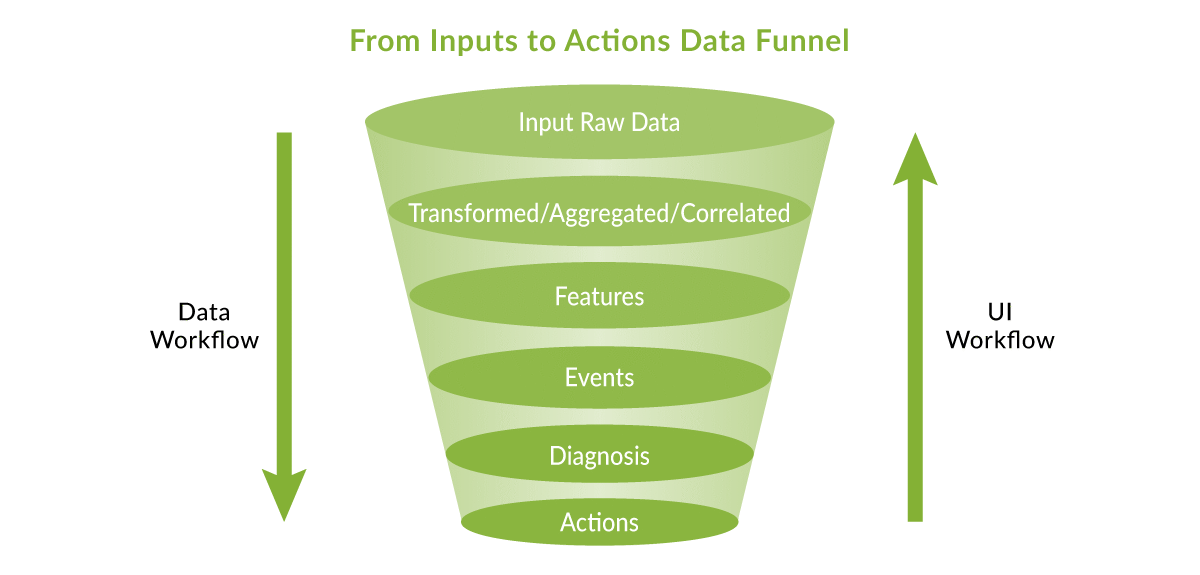

最初的原始数据要切实有用,就必须能够最终带来行动建议或落实的行动。一开始就要求用户信任一个完全自主的工作流,往往是痴人说梦,所以建议让用户自下而上逐步了解各个支持层。通过逐级深入研究事件,用户界面 (UI) 工作流能够帮助您层层剖析,直至挖掘到原始输入。这有助于提高透明度和建立信任。

建立一个框架,让领域专家得以深入挖掘、释疑,让新手得以搜索、解惑,不仅可以同时帮助初学者和老手提高生产力、积累知识,还能够建立起他们对 AI 的信任。这种参与形式还有助形成一种良性循环,可以进一步训练和打磨 AI/ML 算法,以实现持续的系统改进。

人工智能驱动型用户界面中的数据流

如何使用可解释的 AI 来评估和降低风险

数据网络拥有定义明确的协议和数据结构,意味着 AI 可以得到令人难以置信的发展,而不用担心存在歧视或人类偏见。当处理诸如故障排除和服务保证等中性问题时,可以信赖并负责任地采用 AI 应用。

让供应商回答若干技术和操作基础问题,对于揭露和避免“AI 漂洗”而言极其重要。与任何尽职调查和采购工作一样,答案越详尽,就越能够重要洞见。回答可能需要辅以技术解释,但我们仍然建议供应商提供详尽回答,以确保供应商的主张是切实可行的。

与任何技术一样,工程和领导团队要制定标准评估拟行采购,并且相关决策要以证据为基础。为了降低风险和帮助完成尽职调查,AI/ML 所有者和用户可以提出如下示例问题:

- 该解决方案包含哪些算法,这些算法对解决方案又有什么作用?

- 输入的数据以及数据的清理方式有哪些?

- 数据源自哪里(是根据租户、帐户还是用户定制的)?

- 如何通过网络空间设计参数和功能?

- 如何训练、再训练模型,并保持模型及时更新和相关?

- 系统本身是否能解释其推理、建议或行动?

- 如何消除或减少偏见?

- 解决方案或平台是如何自动改进和演进的?

此外,始终建议进行试点或试验,以验证关于 AI 服务或系统的承诺或声明。

可解释的 AI 在瞻博网络的应用

如何负责任且合乎道德地使用 AI 是一个复杂的课题,但也是组织必须解决的问题。瞻博网络 Mist AI 创新原则指导我们在服务和产品中使用 AI。我们还编写了很多关于 AI/机器学习以及我们的 AIOps 方法的文章,包括 AI 数据和初期发展历程、人工智能驱动型问题解决方法、界面和智能聊天程序,这些文章有助于检测和纠正网络异常问题,同时使用更先进的工具改进运维。

XAI 可以以多种形式出现。例如,瞻博网络 AIOps 的功能包括在 Wi-Fi 网络中执行自动无线资源管理 (RRM) 和检测问题,例如网络电缆故障。Mist 产品界面提供了部分瞻博网络 XAI 工具,您可以在我们的自助服务之旅中自行演示。在此注册,立即获取。

对于用户和运维人员,请留意基于 Mist AI™ 引擎和 Marvis 虚拟网络助手的产品中的一系列新功能,这些功能将围绕方法、模型、决策和置信水平展示更强的可解释性,从而提高信任度和透明度。

有关可解释的 AI 的常见问题

“可解释的 AI”是什么意思?

可解释的 AI (Explainable AI) 是方便用户理解和信赖由 AI 机器学习 (ML) 算法计算所得结果和输出的一套过程和方法。有关 AI/ML 输出的补充解释或许只面向用户、运维或开发人员,但这些解释旨在解决用户采用、管理和开发系统等方面的各种问题和挑战。

什么是可解释的 AI 模型?

可解释的 AI 模型拥有可提高透明度、促进理解的特性或属性,且具备对 AI 输出提出质疑或质询的能力。

可解释的 AI 的重要性在何?

由于可解释的 AI 能够详细描述 AI 系统输出的基本原理,因此,它能够帮助人们加强、培养和建立部署 AI 系统所必要的理解、管理能力和信任,并增加对其输出和结果的信心。如果没有 XAI 帮助建立信任和信心,人们就不可能广泛部署 AI 或从 AI 技术中受益。

可解释的 AI 的好处有哪些?

可解释的 AI 好处良多。这些好处涉及明智决策、降低风险、增加信心和用户接纳度、优化管理、加速系统改进,以及促进 AI 在全球全面发展与应用等。

可解释的 AI 实际存在吗?

当然存在,但由于可解释的 AI 的定义仍在不断演变,其仍处于萌芽阶段。虽然在拥有大量功能或阶段的复杂或混合 AI/ML 模型上实现 XAI 将面临更大的困难,但 XAI 正积极寻找融入产品和服务的方法,以建立用户信任并促进加快发展。

什么是深度学习中的可解释性?

深度学习有时被视为“黑箱”,这意味着人们很难理解深度学习模型的行为以及其作出决定的方式。提高可解释性旨在为人们提供有关深度学习的解释。Shapley 是一项用于解释深度学习模型的技术。SHAP 值可以通过突出显示预测中涉及的特征来解释特定预测。目前有针对不同的解释评估方法进行持续研究。

瞻博网络提供哪些可解释的 AI 功能?

XAI 可以以多种形式出现。例如,瞻博网络提供了博客和视频资源,描述了用于多种 AIOps 功能的 ML 算法,包括在 Wi-Fi 网络中执行自动无线资源管理 (RRM) 或故障网络电缆检测(请参见下面的视频资源)。Marvis 应用体验洞察仪表板使用 SHAP 值来识别导致应用体验不佳的网络状况,如 Zoom 视频不流畅。Mist 产品界面提供了部分 XAI 工具,您可以在我们的自助服务之旅中自行演示。在此注册,立即获取。