ソリューションブリーフ:AIデータセンター構築向けのジュニパーの検証済み設計(JVD)

お客様のAIの実現をサポートする、実証済みで繰り返し可能なデータセンターネットワーク設計

AIデータセンターの設計と導入のサポートならお任せください。

課題

AIクラスター向けのネットワークを設計する際の主な目的は、ロスレスファブリックを介したAIトラフィックフローで、最大のスループット、最小限の遅延、最小限のネットワーク干渉を実現することです。

これまでにないほど増大したAIネットワーク需要

人工知能(AI)と機械学習(ML)トレーニングは膨大な並列処理問題であり、AIクラスターワークロードの要求を処理するために世界でも最も洗練されたデータセンターネットワークが必要とされます。AIクラスターは、フローの変動が最小限に抑えられた頻繁なエレファントフローとして見られる高密度なトラフィックパターンが特徴で、ネットワークインフラストラクチャに独自の要件をもたらします。他の新技術と同様に、AI/MLのクラスター学習曲線も急峻なため、時間とコストの遅延が発生し、AI/MLアーキテクチャにとって非常に高コストになります。

AIデータセンターネットワークは、フロントエンド、バックエンド、ストレージで構成されており、拡張性のあるものでなければなりません。ジョブ完了時間(JCT)を最小限に抑えるために、バックエンドとストレージコンポーネントがシームレスに連携する必要があります。これは非常に重要で、わずかな効率低下でも、モデルのトレーニング時間を大幅に増やす可能性があります。

分散型MLワークロードから生成されるデータセンター内のトラフィックは、他のほとんどのアプリケーションを凌駕する量です。大規模なデータセットを伝達し、数十億または数兆個のモデルパラメータを処理する必要のあるAI要件は、ネットワークに重い負荷をもたらします。

特長

完全にテスト済みの、十分にドキュメント化されたネットワーク設計

AI/MLパフォーマンスを最適化するには、スピードと効率性を確保するために、グラフィック処理ユニット(GPU)の利用を最大限に高める必要があります。

ジュニパー検証済み設計(JVD)は、プロセスを簡素化しAIへの投資を節約するために、フロントエンドおよびバックエンドデータセンターの設計図を提供することで、安定稼働までの時間とジョブ完了時間(JCT)を短縮し、AI推論パフォーマンスを最適化します。

- 再現性

すべてのJVDユーザーが、世界中で行われた導入から学んだ教訓のメリットを得られる規定設計

- 信頼性

現実世界のトラフィックでテストされ、測定可能な結果で説明されている、統合型のベストプラクティス設計

- スピード

ステップバイステップのガイダンス、自動化、事前構築済みの統合で、導入とアップグレードを合理化

- 一貫性

JVDがはるかに厳格で安定しており、メンテナンス可能なネットワークを実現

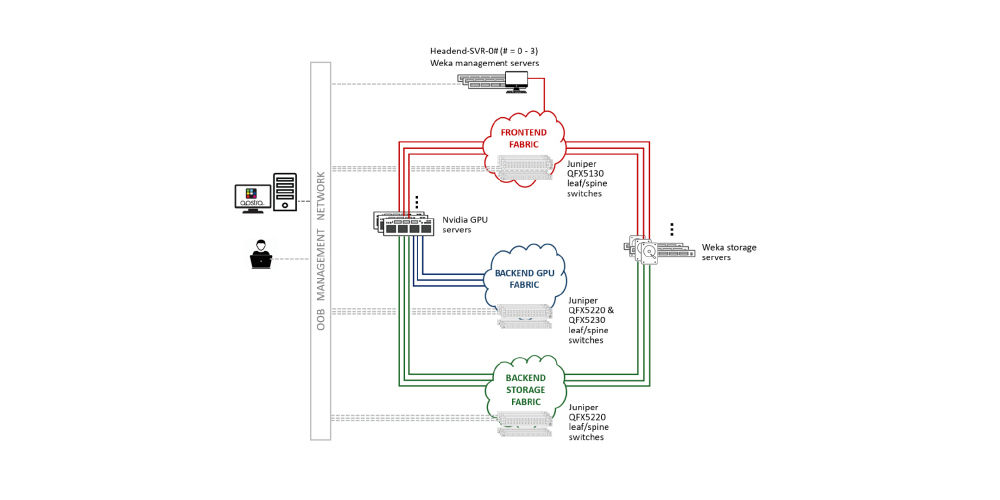

図1

AIデータセンターの設計

JVDは、以下の3つの独立したファブリックを含む、エンドツーエンドのイーサネットベースのAIインフラストラクチャすべてをカバーします。

- フロントエンドファブリック:GPUノードやストレージノードへのゲートウェイネットワークとなるファブリックです。ユーザーとシステムはここからGPUクラスターにアクセスします。

- バックエンドGPUファブリック:保存されたデータセットから大規模なモデルをメモリに消費するGPUを接続し、フロントエンドネットワークからのリクエストを促進するファブリックです。バックエンドGPUファブリック内のノード(サーバー)が、学習イベントやトレーニングイベント中に、GPU間でロスレスネットワークを必要とする高速情報を送信します。

- バックエンドストレージファブリック:大規模なモデルトレーニングデータを保持する高可用性ストレージシステムを接続するファブリックです。バックエンドストレージファブリックは、モデル学習向けにGPUへのシームレスで信頼性の高いデータ配信を確保する必要があります。

これら3つのファブリック(図1)は共生関係にあり、それぞれがトレーニングや推論に独自の機能を提供します。

ファブリックは、AIモデルトレーニングとGPUジョブの完了において、ネットワークがボトルネックにならないように設計されています。NVIDIAは、通信遅延を最小限に抑える「レール最適化」と呼ばれるネットワーク設計を規定しています。

レール向けに最適化された設計では、各サーバーに8つのネットワークインターフェイス(GPUごとに1つ)が存在します。各々のGPUインターフェイスが、個別のリーフスイッチにケーブル接続されています。フロントエンド、ストレージ、バックエンドGPUコンピュートインターフェイスは、それぞれ独立した別の専用ネットワーク上にあります。Juniper Apstraは、これら3つのファブリックすべてを同じApstraインスタンス内の設計図として管理するのに理想的です。

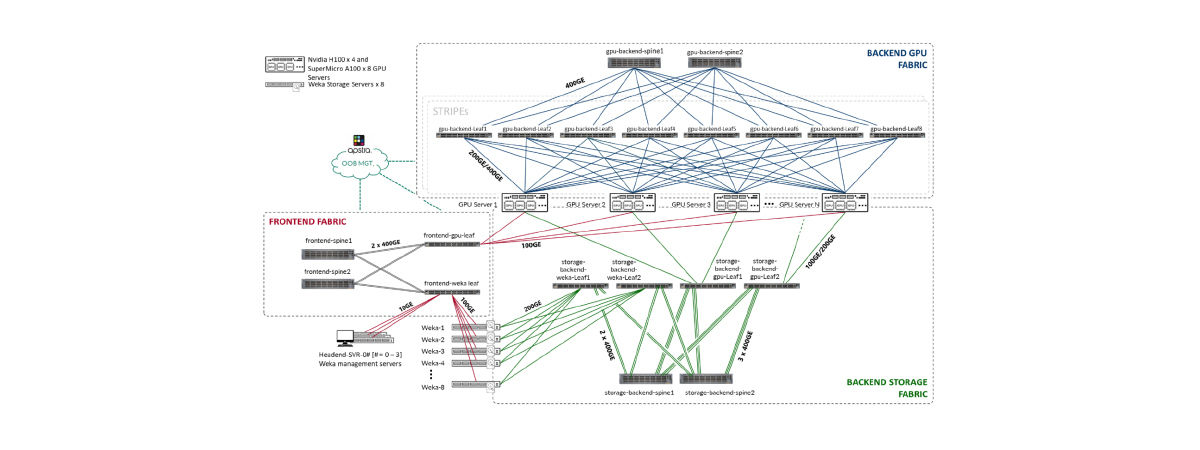

図2

ソリューションアーキテクチャ

図2は、レール向けに最適化されたソリューションアーキテクチャを示しています。すべてのファブリック、特にGPUサーバーとQFXリーフスイッチ間のバックエンドGPUファブリックに備わる高性能接続に注目してください。

QFXシリーズスイッチで構築されたファブリックを備えたジュニパーデータセンターネットワークは、オープンなイーサネットインフラストラクチャで高い性能を発揮します。ファブリックはAIパフォーマンス需要を満たすために複雑になりますが、インテントベースの自動化により、ネットワーク事業者がこのような複雑さに悩まされることはありません。

ベストプラクティスの推奨事項に従うため、各ファブリックには最低4本のスパインを設けることを推奨します。トラフィックのロードバランシングとサービスクラス(CoS)の使用は、バックエンドGPUファブリックのロスレスファブリックを確保するために採用されるべきであり、場合によっては、ベンダーの推奨に従ってバックエンドストレージファブリックのロスレスファブリックを確保する必要があります。レール向けに最適化されたファブリックを導入することで、帯域幅のサブスクリプションとリーフ対GPUの対称性を1対1に保つことができます。

仕組み

機能とメリット

AIデータセンター向けJVDは規定ベストプラクティスアプローチであり、ジョブ完了までの時間を最小限に抑え、限られたITリソースで管理を簡略化する高性能なAIトレーニングと推論ネットワークを展開することができます。アーキテクチャは、AIトレーニングパフォーマンスの要求を満たすだけでなく、それを上回ります。

コア機能

ボトルネックは一切なし

フロントエンド、バックエンドGPU、バックエンドストレージファブリックにより、AIモデルトレーニングやGPUジョブの完了によって、ネットワークがボトルネックになることは決してありません。

レール向けに最適化された設計

通信遅延を最小化

インテントベースの自動化

ネットワーク運用担当者をデータセンターファブリックの複雑さから解放

ジュニパーのソリューションが実現

JVDプログラムは、特徴が十分に記載された多次元的なソリューションを開発することで、ネットワークチームが抱える複雑さを軽減します。

JVDでバックアップされた物理インフラストラクチャが、ソリューションの実行可能性を証明しており、結果はテストレポートとして提供されます。

メリット

ジュニパーのメリット

ジュニパーのAIデータセンターネットワークは、業界標準の専用IPファブリック設計に従っています。3つの異なるファブリック(バックエンド、フロントエンド、ストレージファブリック)が、AIモデルの拡張、完成までの時間の短縮、AI技術の登場による急速な進化に着目し続けながら、最大の効率性を提供します。

最適なハードウェアとともに構成が提供されます。全体において、最適なプラットフォームのこのJVDで指定されている機能、パフォーマンス、役割などの面が詳しく説明されています。

AI JVD設計により、事業者は必要な製品や技術に関する深い前提知識を必要とすることなく、トレーニングクラスターを体系的にオーケストレーションすることができます。

ジュニパーを選ぶ理由

The NOW Way to Network

ジュニパーネットワークスは、単なる接続性は優れた接続エクスペリエンスと同じではないと考えています。ジュニパーのAIネイティブネットワーキングプラットフォームは、AIを活用するためにゼロから構築されており、エッジからデータセンター、クラウドにいたるまで、高い安全性と持続可能性を備えた非常に優れたユーザーエクスペリエンスを提供します。詳細については、ジュニパーネットワークス (www.juniper.net/jp/ja)をご覧いただくか、X(Twitter)、LinkedIn、Facebookでジュニパーをフォローしてご確認ください。

詳細はこちらをご覧ください:

Juniper Apstra、NVIDIA GPU、WEKA Storage—JVDを採用したAIデータセンターネットワークの詳細については、https://www.juniper.net/documentation/us/en/software/jvd/jvd-ai-dc-apstra-nvidia-weka/index.html(英語)をご覧ください。

技術データシート、ガイド、ドキュメントについては、https://www.juniper.net/documentation/validated-designs/(英語)をご覧ください。